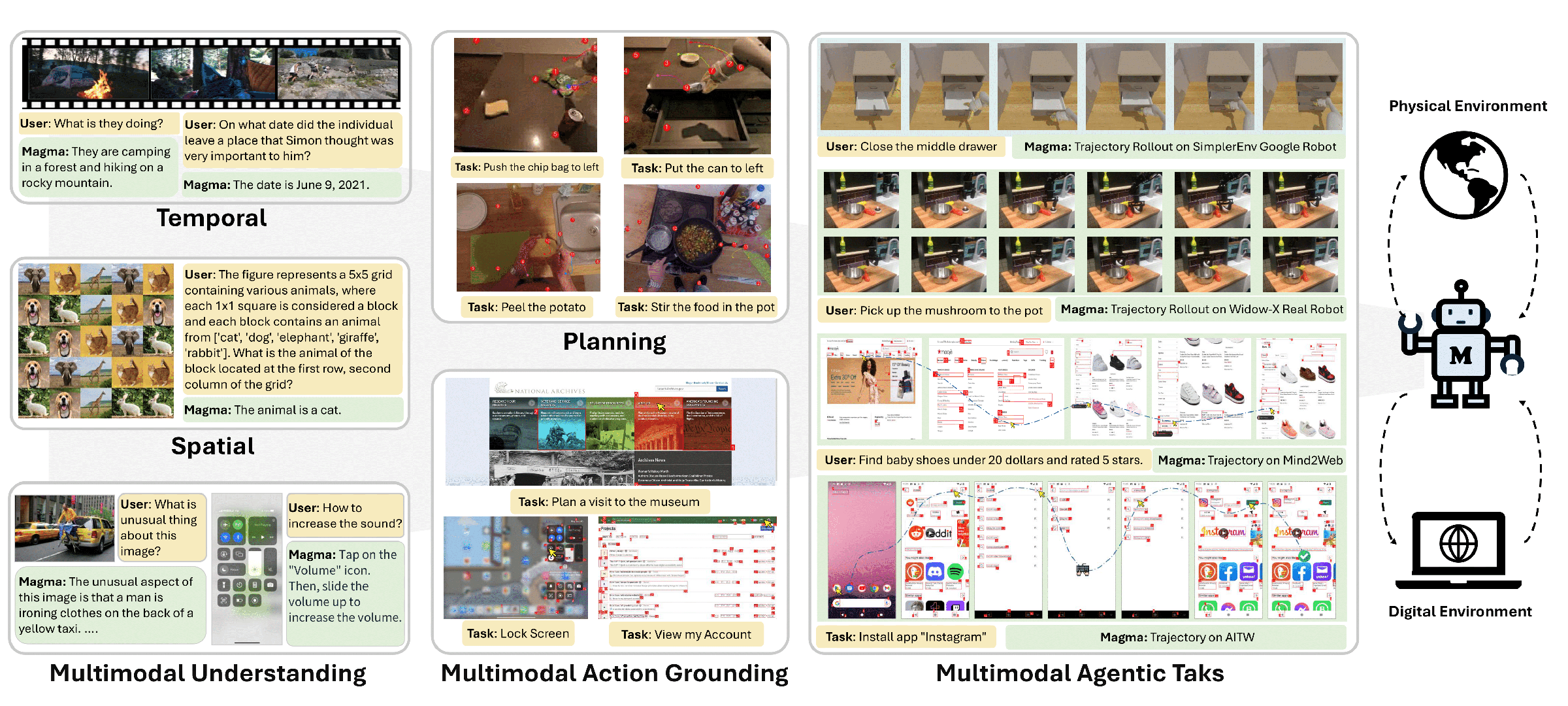

Microsoft Magma to przełomowy model sztucznej inteligencji, który łączy przetwarzanie języka naturalnego, analizę wizualną oraz planowanie akcji w środowiskach cyfrowych i fizycznych.

Jak wynika z badań opublikowanych 18 lutego, Magma przekracza możliwości tradycyjnych systemów wielomodalnych, integrując inteligencję werbalną (rozumienie semantyki) z inteligencją przestrzenno-czasową (planowanie ruchu w 2D/3D). Dzięki temu model potrafi zarówno interpretować złożone polecenia tekstowe, jak i wykonywać sekwencje działań – od klikania przycisków w interfejsie użytkownika po manipulację obiektami przez ramiona robotyczne.

Elastyczność wyrażona przez multimodalność. Magma rozumie otaczający ją świat

Elastyczność wyrażona przez multimodalność. Magma rozumie otaczający ją światKluczową innowacją Magmy jest unifikacja trzech kluczowych kompetencji w jednym modelu:

- Percepcja wielomodalna – jednoczesne przetwarzanie strumieni wideo, danych sensorycznych z robotów i tekstu.

- Planowanie hierarchiczne – dzielenie złożonych zadań na sekwencje akcji (np. przygotuj kawę – podnieś kubek – wlej wodę).

- Egzekucja w środowisku – transformacja abstrakcyjnych poleceń na konkretne ruchy w przestrzeni (np. współrzędne kliknięcia myszką lub trajektorię chwytaka robota).

To też jest ciekawe:

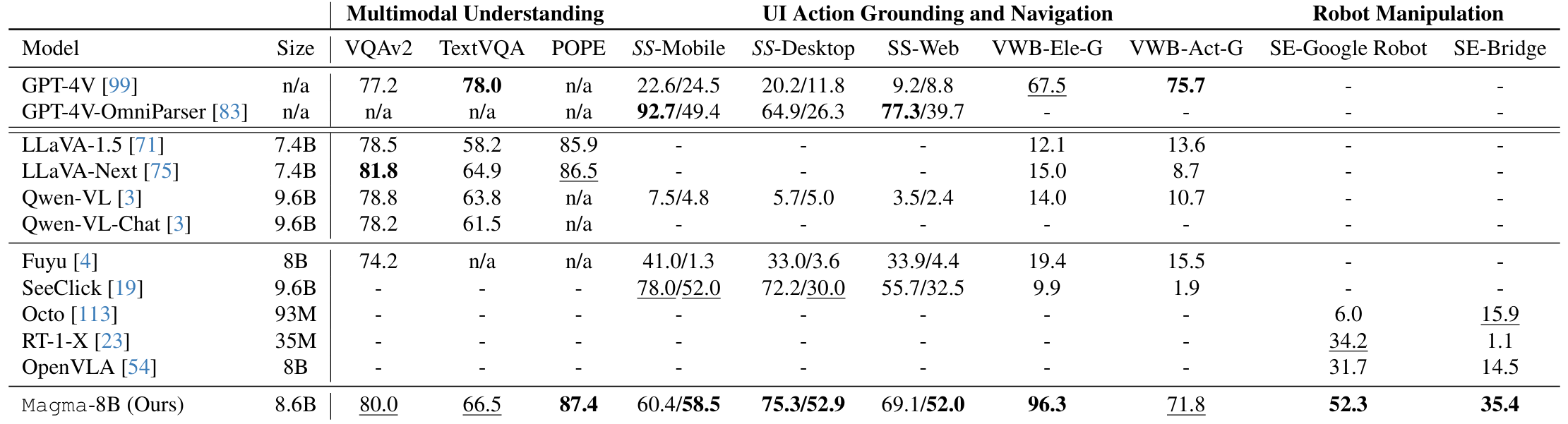

W przeciwieństwie do wcześniejszych rozwiązań, takich jak Google PALM-E czy OpenAI Operator, Magma eliminuje konieczność stosowania oddzielnych modeli dla percepcji i kontroli. Jak wykazano w eksperymentach na zestawie Mind2Web, model osiągnął 89,7 proc. skuteczności w zadaniach nawigacji UI, przewyższając specjalistyczne systemy o 12,3 proc.

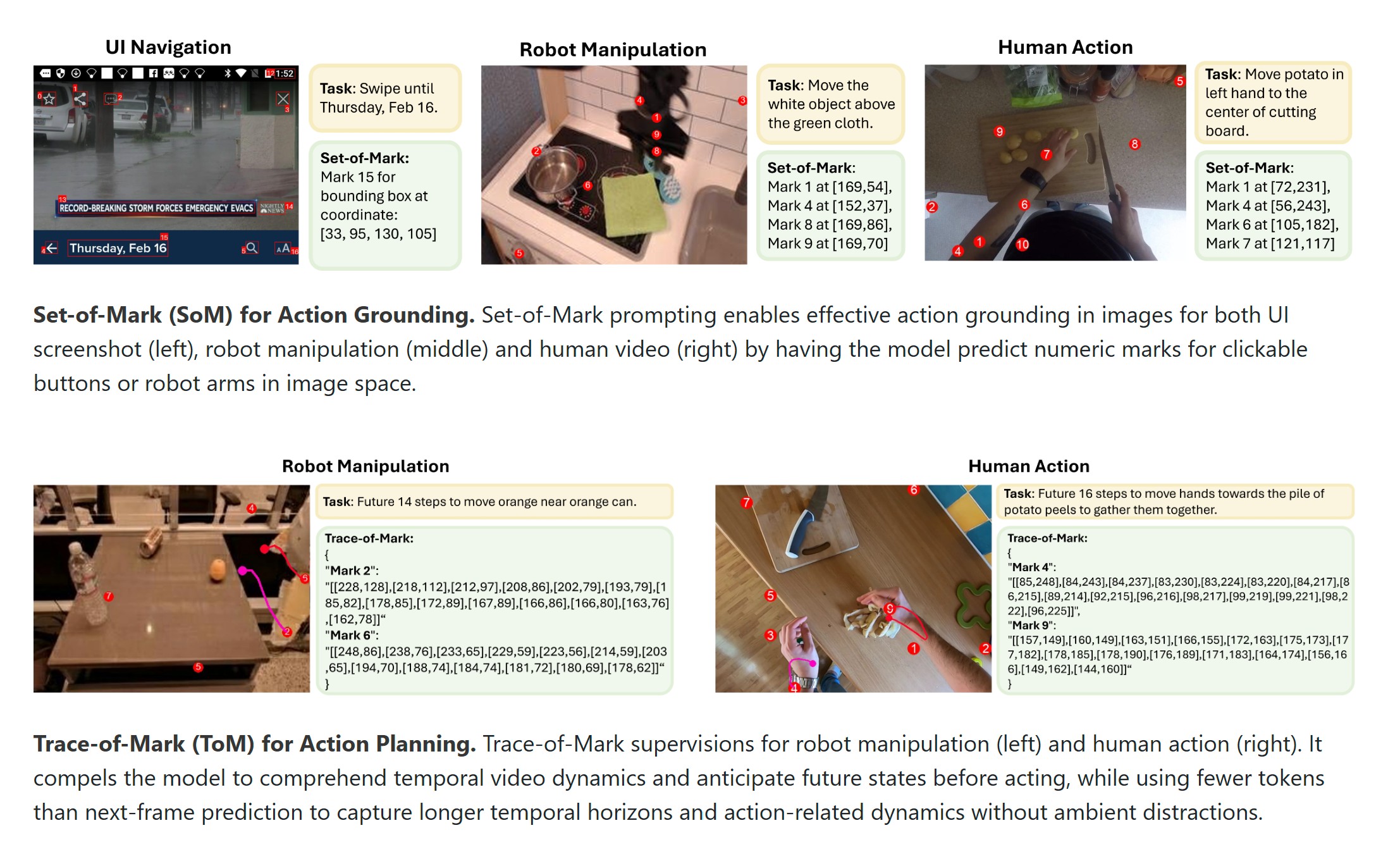

Set-of-Mark (SoM) i Trace-of-Mark (ToM) – inżynieria akcji

Jak działa Set-of-Mark i Trace-of-Mark? Microsoft wyjaśnia

Jak działa Set-of-Mark i Trace-of-Mark? Microsoft wyjaśniaSednem możliwości akcyjnych Magmy są dwie autorskie techniki anotacji danych:

- Set-of-Mark (SoM) – oznaczenie interaktywnych elementów w obrazach (np. przycisków w GUI lub uchwytów szafki dla robota) dzięki cyfrowych znaczników. Pozwala to modelowi mapować polecenia tekstowe na konkretne współrzędne pikseli.

- Trace-of-Mark (ToM) – śledzenie trajektorii obiektów w klipach wideo (np. ruchu ręki ludzkiej lub robota). Dzięki temu Magma uczy się przewidywać konsekwencje akcji i planować sekwencje ruchów.

W trakcie pre-treningu na 39 mln próbek (w tym 2,7 mln zrzutów ekranów UI i 970 tys. trajektorii robotycznych) model nabywa umiejętność generalizacji – zasady poznane w środowisku cyfrowym (np. przycisk OK w oknie dialogowym) przekładają się na manipulację fizycznymi obiektami.

Magma rewolucjonizuje interakcję z oprogramowaniem poprzez:

- kontekstową nawigację UI – model analizuje strukturę aplikacji (np. menu Photoshopa) i wykonuje złożone workflow (np. wyostrz zdjęcie i eksportuj do PDF)

- Adaptację do dynamicznych zmian – w przeciwieństwie do sztywnych skryptów RPA, Magma potrafi dostosować się do aktualizacji interfejsu dzięki rozumieniu semantyki elementów.

I robi to dobrze. To nie tylko teoria, roboci mózg Microsoftu wypada świetnie również w praktyce

W testach na mobilnej aplikacji Airbnb model zautomatyzował proces rezerwacji z 94 proc. dokładnością, przewyższając specjalizowane narzędzia jak UiPath. W domenie fizycznej Magma wykazuje się w manipulacji miękkimi obiektami (eksperymenty z chwytaniem soczystych owoców wykazały 78 proc. skuteczność vs. 62 proc. dla OpenVLA), planowaniu ruchu w 3D (algorytm generuje trajektorie uwzględniające dynamikę manipulatorów (np. bezwładność ramion) i we współpracy człowiek-robot (model interpretuje komendy głosowe (podaj klucz płaski) i dostosowuje siłę chwytu do kontekstu).

W symulacjach środowiska LIBERO, dotyczących logistyki magazynowej, Magma osiągnęła 82 proc. sukcesu w zadaniach kompletacji, redukując czas szkolenia robotów o 70 proc. w porównaniu do tradycyjnego programowania.

Jak działa Microsoft Magma?

Magma łączy trzy najważniejsze komponenty. Pierwszym jest enkoder wizualny ConvNeXt-XXL, który przetwarza obrazy i klatki wideo w rozdzielczości do 2000 pikseli, zachowując detale potrzebne do precyzyjnej interakcji. Drugi to model językowy LLaMA-3-8B, który analizuje intencje użytkownika i generuje instrukcje akcji w notacji tekstowej. Trzeci to mechanizm uwagi przestrzennej, który łączy reprezentacje wizualne z poleceniami tekstowymi, umożliwiając np. kliknięcie w określony obszar ekranu na podstawie opisu.

W odróżnieniu od architektur typu two-tower Magma stosuje wspólną przestrzeń embeddingową dla wszystkich modalności, co redukuje opóźnienia o 40 proc. najważniejsze etapy szkolenia modelu obejmują:

- Pre-trening wielomodalny – 25 mln klipów wideo z Epic-Kitchens i Ego4D, wzbogaconych adnotacjami SoM/ToM.

- Dostrojenie zadaniowe – 390 tys. próbek z robotyki (Open-X-Embodiment) i 650 tys. interakcji UI (Mind2Web).

- Optymalizacja RLHF – ludzkie oceny jakości wykonanych akcji w środowisku symulacyjnym Microsoft Genesis.

Wyniki pokazują, iż zastosowanie SoM zwiększa dokładność lokalizacji obiektów o 19 proc., a ToM poprawia płynność trajektorii ruchu o 28 proc.

Użyliśmy wielu mądrych słów. Ale co wynalezienie Magmy może oznaczać w praktyce?

W kwestii multimodalności Magma nie ma sobie równych. I to mimo wysokich wyników w każdej z kategorii z osobna

W kwestii multimodalności Magma nie ma sobie równych. I to mimo wysokich wyników w każdej z kategorii z osobnaMicrosoft Magma jest na dziś jedyny w swoim rodzaju, wyznaczając tym samym nowy paradygmat w integracji SI ze światem fizycznym i cyfrowym. Dzięki połączeniu precyzyjnej percepcji, adaptacyjnego planowania i bezpiecznej egzekucji, model otwiera drogę do zastosowań w automatyzacji przedsiębiorstw, personalnej robotyce oraz asystentach AI nowej generacji.

Wyzwaniem pozostaje skalowanie na miliony urządzeń IoT oraz zapewnienie transparentności decyzji modelu. W perspektywie 2026 r. oczekuje się integracji Magmy z ekosystemem Azure, co może zrewolucjonizować branże od produkcji po opiekę zdrowotną. Pod warunkiem iż wszystko pójdzie zgodnie z planem.