Niedawno udostępnione modele rozumowania mierzą się z poważnymi problemami. Eksperci informują bowiem o halucynacjach popełnianych przez o3, a także o4-mini. Warto zwrócić na to uwagę, ponieważ do takich sytuacji dochodzi znacznie częściej niż w przypadku starszych i mniej zaawansowanych rozwiązań. Generowanie nieprawdziwych czy zmyślonych informacji to wręcz zaprzeczenie idei narzędzi mających pomagać w pracach badawczych lub opracowywaniu złożonego kodu. Czy zatem możemy liczyć na wdrożenie stosownych poprawek?

OpenAI nie dowiózł idealnych produktów

Pięć dni minęło od zapowiedzi modeli o3 oraz o4-mini. Jak informowaliśmy w poprzednim wpisie, nowości wyróżniają się przede wszystkim umiejętnością analizowania materiałów graficznych podczas procesu myślowego. To prawdziwy przełom dla wszystkich osób, które podczas pracy wykorzystują treści wizualne wszelkiej maści. Do tego doszła również pełna integracja z funkcjami dostępnymi na łamach ChatGPT.

- Sprawdź także: OpenAI się nie zatrzymuje. o3 i o4-mini to nowe potężne modele

Fakty mówią same za siebie – zaprezentowane światu narzędzia są nowoczesne, zaawansowane i turbo wydajne. Nie oznacza to jednak, iż nie posiadają żadnych poważnych wad. Eksperci donoszą o niepokojących zdolnościach o3 i o4-mini do halucynacji, a także wymyślania niestworzonych rzeczy. Modele mają robić to znacznie częściej niż swoi poprzednicy (o1, o1-mini, o3-mini oraz GPT-4o). Jak więc widzicie, największa bolączka sztucznej inteligencji przez cały czas nie została rozwiązana.

ChatGPT (Android) – pobierz aplikację z naszej bazy danych

Halucynacje pojawiają się w każdym modelu i prawdopodobnie wiele lat minie zanim AI zacznie generować same fakty bez żadnego wyjątku. Zawsze jednak było tak, iż kolejna generacja sztucznej inteligencji radziła sobie pod tym względem coraz lepiej. Nie jest tak w przypadku najnowszej technologii, co zasługuje na szczególną uwagę. Być może doszliśmy do momentu, gdy lepiej po prostu już być nie może?

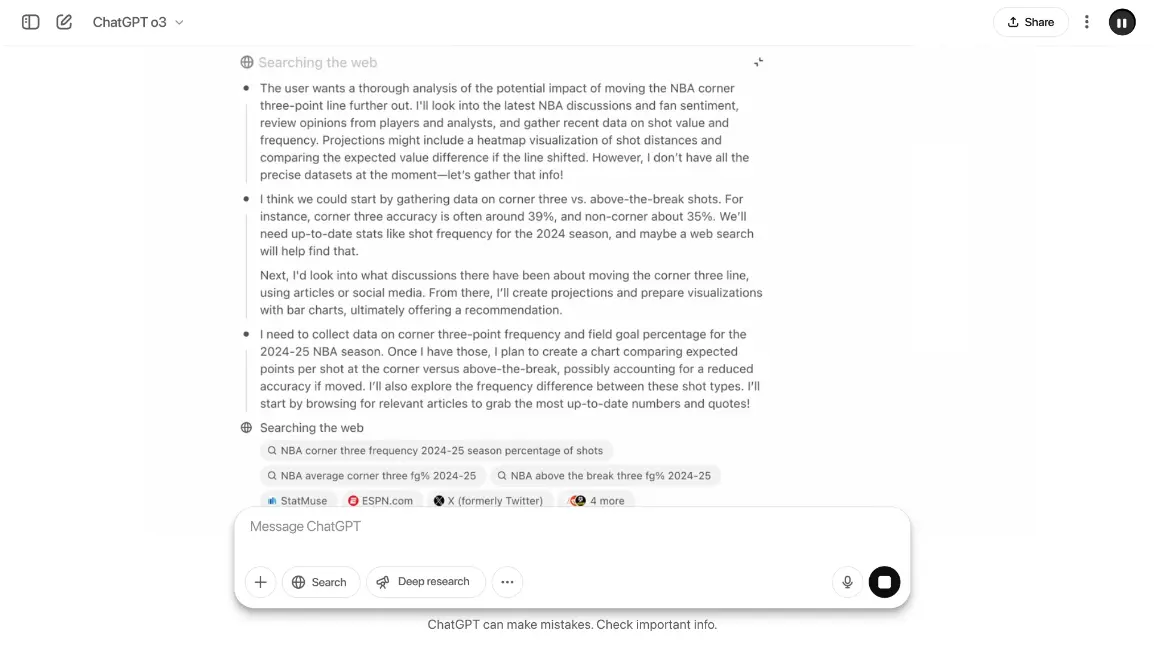

Model rozumowania o3 w praktyce / Źródło zdjęcia: OpenAI

Model rozumowania o3 w praktyce / Źródło zdjęcia: OpenAIDlaczego jest gorzej i jak temu zapobiec?

Odpowiedź na pytania zadane w nagłówku brzmi: nie wiadomo. OpenAI bez ogródek przyznaje, iż nie do końca wie dlaczego doszło do wzrostu wskaźnika halucynacji. Wykażą to dopiero badania, trudno jedna powiedzieć kiedy ich wyniki ujrzą światło dzienne. Skalowanie modeli rozumowania pogarsza niektóre aspekty AI – teraz należy znaleźć sposób, by temu zapobiec. jeżeli zaś chodzi o konkretne liczby, to nie napawają one przesadnym optymizmem.

Model rozumowania o3 generuje średnio 33% nieprawidłowych odpowiedzi, natomiast o4-mini około 48%. Dla porównania: o1 uzyskał wynik na poziomie 16%, natomiast o3-mini może pochwalić się rezultatem wynoszącym 14,8%. Mamy zatem do czynienia z kolejnym wyzwaniem stojącym przed firmami zajmującymi się rozwojem sztucznej inteligencji.

- Przeczytaj również: GPT-4.1 oficjalnie. Nowy model jest szybszy i znacznie mądrzejszy

Co ważne, halucynacje bywają pomocne w przypadku zadań wymagających kreatywności czy wymyślania absurdalnych scenariuszy. Występowanie tego zjawiska jest jednak niedopuszczalne w rozmowach cechujących się dokładnością czy precyzją. Dlatego też pozostaje mieć nadzieję, iż kolejne twory OpenAI będą pozbawione halucynacji na poziomie 48%, co samo w sobie brzmi niedorzecznie.

Źródło: TechCrunch / Zdjęcie otwierające: wygenerowane przez AI (ChatGPT)