Naukowcy z Uniwersytetu Cornella opracowali nowy, rewolucyjny system trenowania robotów o nazwie RHyME (skrót od ang. Retrieval for Hybrid Imitation under Mismatched Execution). Ten system wykorzystujący sztuczną inteligencję sprawia, iż robot może nauczyć się wykonywania zadania po obejrzeniu zaledwie jednego filmu instruktażowego z udziałem człowieka.

To przełomowe osiągnięcie, biorąc pod uwagę, iż dotychczas roboty wymagały bardzo precyzyjnych instrukcji krok po kroku i ogromnych ilości danych treningowych – często liczonych w setkach godzin nagrań. Gdy coś poszło niezgodnie ze scenariuszem – na przykład robot upuścił narzędzie albo element wymknął się spod kontroli – tradycyjne podejścia zwykle zawodziły i maszyna po prostu przerywała pracę, nie wiedząc co dalej.

Robot uczy się jak człowiek

Koncepcja RHyME wywodzi się z obserwacji tego, iż ludzie uczą się nowych czynności, podpatrując innych przy pracy, zamiast otrzymywać żmudne instrukcje krok po kroku. Doktorant Kushal Kedia, współautor badania, podkreśla, iż najbardziej kłopotliwe w programowaniu robotów jest gromadzenie olbrzymich ilości danych pokazujących, jak wykonują one rozmaite zadania. Zwraca uwagę, iż ludzie uczą się inaczej – czerpią inspirację, po prostu obserwując innych.

Podobnie RHyME umożliwia robotom uczenie przez naśladowanie – podejście znane w uczeniu maszynowym jako imitation learning, czyli uczenie poprzez imitację ludzkich demonstracji. Naukowcy z Cornell porównują swoje rozwiązanie do tłumaczenia między językami – tutaj „tłumaczony” jest pokaz zadania wykonywanego przez człowieka na sekwencję czynności, które potrafi wykonać robot. Mówiąc prościej, RHyME przekłada to, co widzi na filmie, na zrozumiały dla robota język akcji.

Największym wyzwaniem przy uczeniu z ludzkich demonstracji jest to, iż człowiek wykonuje czynności inaczej niż robot. Ludzkie ruchy są płynne, często angażują obie ręce jednocześnie, a czasem łączą wiele działań naraz – dla robota to trudne do naśladowania. W tradycyjnych metodach najmniejsza pomyłka w sposobie wykonania zadania potrafiła zepsuć cały proces uczenia. W nowym systemie ten to ryzyko nie istnieje. Wypełnia on luki między tym, co robot zobaczył na filmie, a tym, co sam może wykonać. Maszyna korzysta przy tym z własnej pamięci i bazy wcześniej widzianych nagrań, aby połączyć fakty i dopasować swoje akcje do celu zadania.

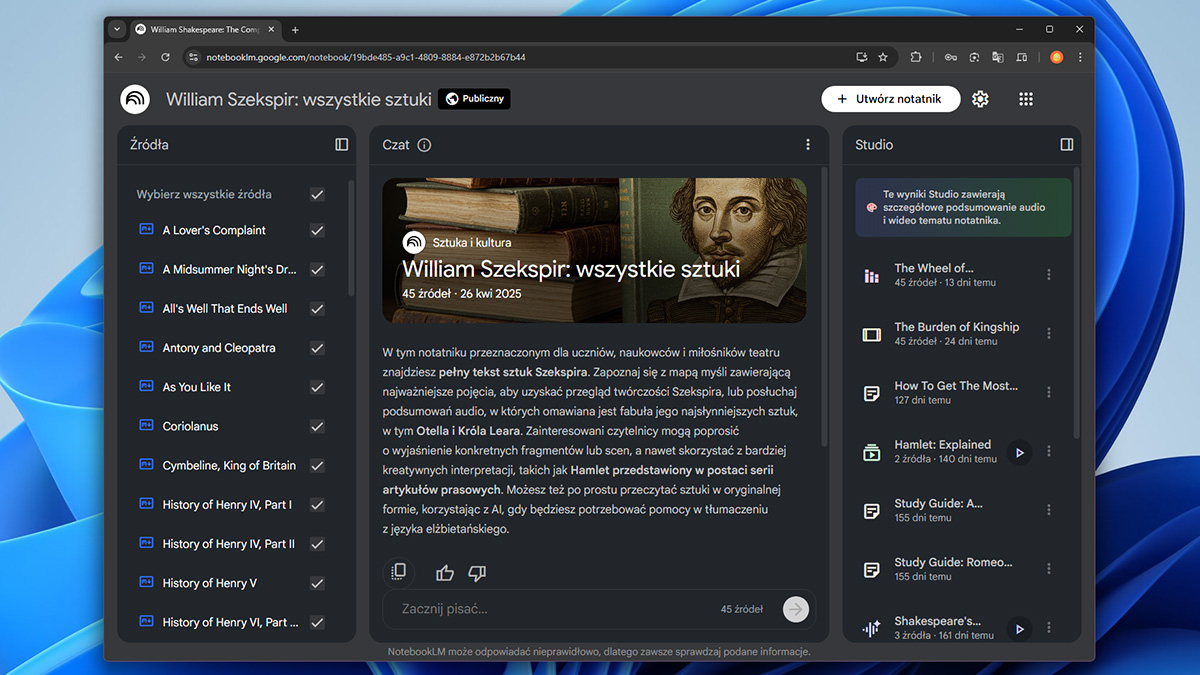

RHyME powtarza czynność / Źródło: Cornell Chronicle

RHyME powtarza czynność / Źródło: Cornell ChronicleMówiąc obrazowo, gdy zaprezentujemy mu film, na którym człowiek zdejmuje kubek z blatu i wkłada go do zlewu, przeszuka on w ułamku sekundy swoje „wspomnienia” z innych projekcji i wyciągnie z nich podobne akcje. Na przykład chwytanie kubka czy ostrożne odłożenie przedmiotu. Łącząc te elementy, wykona polecenie mimo różnic w stylu wykonania. W efekcie robot potrafi samodzielnie połączyć kropki – odnaleźć brakujące ogniwa sekwencji czynności – aby osiągnąć ten sam cel, który przed chwilą zobaczył, zamiast poddawać się, gdy zademonstrowano mu coś, co nie pasuje do jego możliwości.

Pół godziny treningu – o 50% lepsze wyniki

Badacze podkreślają, iż w ten sposób można znacząco przyspieszyć trening robotów w porównaniu do dotychczasowych metod. Nowy system wymaga zaledwie około 30 minut danych treningowych pochodzących z jego ruchów, aby skutecznie nauczyć go danego zadania. Mimo tak niewielkiej ilości ćwiczeń, osiągnięte wyniki w warunkach laboratoryjnych, były ponad 50% skuteczniejsze niż dotychczasowe. Dla porównania, tradycyjne podejścia często potrzebowały setek, a choćby tysięcy godzin manualnego sterowania robotem (tzw. teleoperacji) w procesie nauki – co w praktyce bywa niewykonalne.

Przełomowa metoda uczenia z jednego filmiku przybliża nas do domowych robotów-asystentów. niedługo maszyna mogłaby obejrzeć krótkie nagranie i potem samodzielnie odkurzyć, ugotować zupę czy złożyć pranie. Taka technologia sprawdziłaby się też przy opiece nad seniorami: robot naśladuje ruchy opiekuna i reaguje na nieprzewidziane sytuacje. Zamiast żmudnego kodowania wystarczy więc pokazać urządzeniu, co ma zrobić. jeżeli wyniki z laboratorium potwierdzą się w praktyce, niebawem zobaczymy roboty uczące się nowych zadań tak naturalnie, jak robią to ludzie.

Źródło: Cornell Chronicle