Sztuczna inteligencja daje coraz to nowe możliwości przestępcom, którzy czyhają na bezpieczeństwo naszych danych i naszych pieniędzy. Najbardziej niebezpieczne przestępstwa to te związane z przejęciem tożsamości klienta. Najszybciej rosną przypadki zamiany twarzy w systemach, które na takiej właśnie funkcjonalności się opierają. Z jednej strony rozpoznawanie twarzą to funkcjonalność wygodna, z drugiej – rodzi ryzyko.

Zamiana twarzy jest trudna do wykrycia i na tym polu dynamicznie rośnie liczba ataków deepfake. Zakres możliwości działań przestępców, jaki oferuje sztuczna inteligencja (AI), wciąż rośnie. Organizacje przestępcze lub działający na własną rękę hakerzy coraz łatwiej mogą podszywać się w kanałach cyfrowych pod osoby fizyczne. Na czym to polega?

Zazwyczaj ryzyko dotyczy klientów instytucji finansowych i opiera się na przekonującej manipulacji dźwiękiem lub obrazem wideo. Prowadzi to m.in. do wyłudzeń pieniędzy, a także do manipulacji opinią publiczną. Ataki phishingowe oparte na sztucznej inteligencji mogą generować bardzo przekonujące wiadomości. Tak przekonujące, iż trudne jest odróżnienie komunikacji prawdziwej od fałszywej.

Działania przestępców mogą ułatwiać gromadzenie wykradzionych danych osobowych na dużą skalę. Takie dane mogą być następnie przekazywane w darknecie środowiskom przestępczymi i służyć szantażowi.

Rozpoznawanie twarzą – przypadek Genesis Market

Skalę działalności przestępczej dobrze prezentuje przypadek działającej od 2017 roku międzynarodowej grupy działającej pod nazwą Genesis Market. Grupa ta została rozpracowana i zlikwidowana w zeszłym roku przez organy ścigania z 17 państw (w tym Polski).

Genesis Market to także nazwa platformy z łatwym w obsłudze interfejsem. Platforma umożliwiła sfałszowanie tożsamości około dwóch milionów osób. Oferowała przestępcom boty, które infekowały urządzenia ofiar dzięki złośliwego systemu lub przeprowadzały ataki polegające na przejęciu konta.

Cena za bota wahała się od zaledwie 0,7 dolara do kilkuset dolarów, w zależności od rodzaju i ilości kradzionych danych. Najdroższe boty pobierały informacje finansowe umożliwiające dostęp do rachunków bankowości internetowej. Przestępcom oferowano także technologię wykorzystywania danych.

Kupujący takie narzędzie otrzymywali niestandardową przeglądarkę, która miała naśladować przeglądarkę ich ofiar. Umożliwiało to dostęp do konta ofiary bez uruchamiania jakichkolwiek zabezpieczeń platformy, na której znajdowało się konto.

Znany jest przypadek jednego z klientów Genesis Market, który uzyskał dostęp do korporacyjnego konta Electronic Arts (EA). Konto znajdowało się na platformie Slack. Dostęp został uzyskany dzięki danych uwierzytelniających zakupionych za 10 dolarów.

To wystarczyło, żeby doprowadzić do kradzieży kodu źródłowego kilku gier. W chwili zamknięcia platformy w kwietniu 2023 roku Genesis Market oferował ponad 450 tys. tożsamości w 218 krajach świata.

Jaka skala przejmowania tożsamości?

Skalę przejmowania tożsamości można uznać w tej chwili za istotną. Specjalizująca się w cyberbezpieczeństwie firma SpyCloud szacuje, iż w zeszłym roku na świecie ukradziono ponad 9 mln tożsamości. Tylko w III kwartale 2023 roku w USA odnotowano 805 tysięcy takich przypadków. W Polsce jest to ok. 10 tys. rocznie przypadków.

SpyCloud szacuje, iż prób przejęcia tożsamości doświadczyć mogło choćby 22% Amerykanów. Kwoty utraconych środków są niebagatelne. W 2022 roku straty opiewały na 43 mld dolarów. Szczególnym typem przestępstw jest wykorzystywanie syntetycznej tożsamości, opartej na kombinacji sfabrykowanych danych uwierzytelniających. A wygenerowana tożsamość nie jest powiązana z żadną prawdziwą osobą.

Taką metodę za najbardziej niebezpieczną uznają dyrektorzy komórek ds. przeciwdziałania wyłudzeniom w sektorze finansowym. Pokazują to badania Aite Novarica (obecnie Datos Insights). W zeszłym roku ta metoda przyniosła na całym świecie szkody w wysokości 2,4 mld dolarów.

Specjalizująca się w wykrywaniu syntetycznych osobowości i stosowaniu technologii deepfake firma Sumsub podaje, iż w latach 2022–2023 nastąpił znaczny, bo 10-krotny wzrost liczby deepfakes wykrytych na całym świecie.

Największy wzrost, aż o 1740%, miał miejsce w Ameryce Północnej, 1530% w regionie APAC, 780% w Europie, nieco mniejsza była dynamika w innych regionach świata. Krajem najczęściej atakowanym przez deepfakes jest Hiszpania, a najczęściej fałszowanym dokumentem na świecie okazał się paszport Zjednoczonych Emiratów Arabskich.

Badania brytyjskiej firmy biometrycznej iProov wykryły ponad 60 grup zajmujących się tworzeniem syntetycznych tożsamości na całym świecie, liczących od 100 do choćby 100 tysięcy członków.

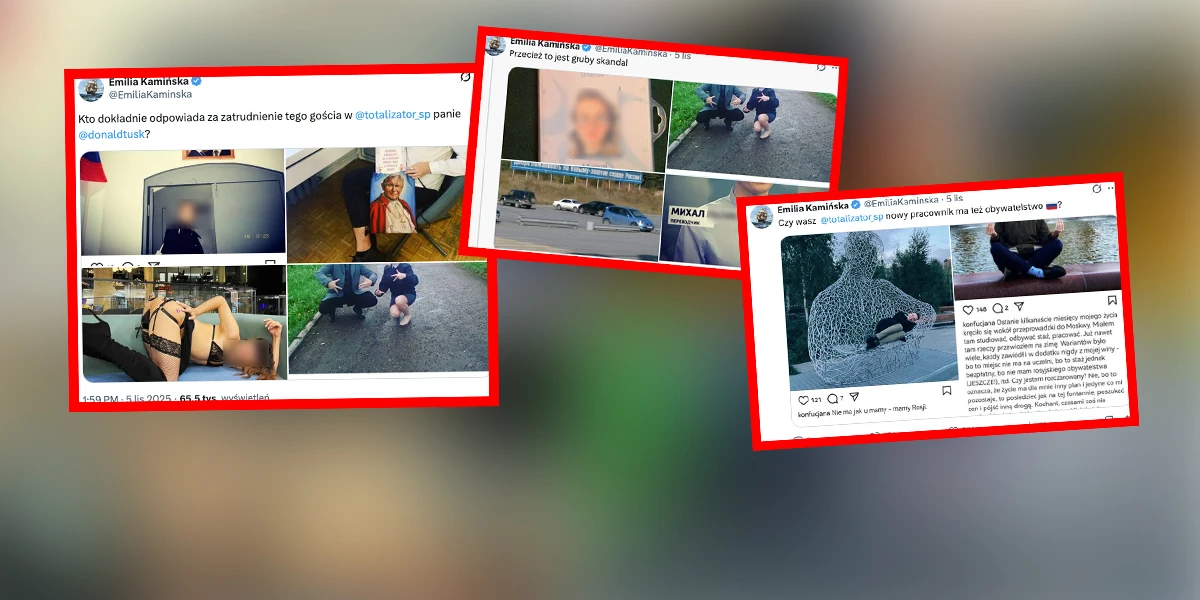

Największe jak dotąd oszustwo

Największe jak dotąd oszustwo typu deepfake miało miejsce w zeszłym roku w Chinach. W tym przypadku przedstawiciel firmy technologicznej został oszukany na ogromną kwotę liczoną w milionach dolarów, o czym pisaliśmy tu. Stało się to po tym, jak odebrał rozmowę wideo od „znajomego”. „Znajomy” okazał się oszustem wykorzystującym technologię zamiany twarzy z udziałem AI.

Sprawa stała się gorącym tematem w mediach społecznościowych po tym, jak policja potwierdziła jej szczegóły. Zdaniem policji nie ma żadnych przeszkód, żeby sztuczną inteligencję wykorzystać do oszukania choćby dobrze wykształconych, świadomych zagrożeń, zajmujących wysokie stanowiska osób.

Rozpoznawanie twarzą i groźna zamiany twarzy

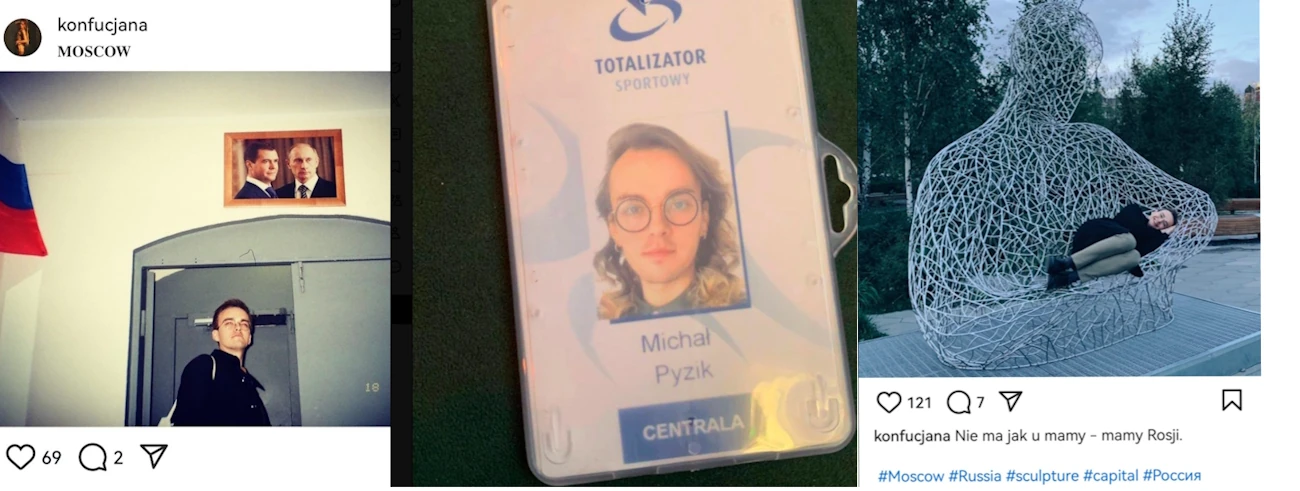

Ataki polegające na zamianie twarzy (face swap attack) stały się najszybciej rosnącą kategorią przestępstw związanych z przejmowaniem tożsamości. Najprostsze, standardowe działanie przestępców polega na manualnym podłożeniu przed kamerę laptopa lub smarfona innego obrazu twarzy lub jej maski, a program przejmuje i zamienia strumień danych wysyłanych po zrobieniu zdjęcia.

Ataki te można jednak wykrywać i zwalczać za pomocą narzędzi weryfikujących oryginalność tożsamości – Presentation Attack Detection (PAD).

Bardziej wyrafinowaną metodą jest tzw. cyfrowy zastrzyk (digital injection). To wyrafinowane, wysoce skalowalne i powtarzalne cyberataki, które omijają kamerę urządzenia lub są wprowadzane do strumienia danych i dotyczą obrazów 2D, wideo i kreowania obrazu poprzez deepfake.

Ataki te zwykle wykorzystują tzw. emulatory do naśladowania urządzenia użytkownika, takiego jak telefon komórkowy, a także fałszowania metadanych w celu ukrycia źródła ataku. Metoda ta jest już używana choćby pięć razy częściej niż zamiana twarzy. Technologia, oferowana także w modelu „as a service”, umożliwia obejście dodatkowych zabezpieczeń takich jak wykonywane na żądanie ruchy głowy, mrugnięcie okiem czy uśmiech (tzw. liveness checks).

Ten sposób jest efektywnym narzędziem uzyskania nieautoryzowanego dostępu do systemów, kont, a także pozwala założyć nowe konta. Zaletą tej technologii dla przestępców jest brak konieczności wyrabiania fałszywych dokumentów, bo mogą wykorzystać te przejęte i poddać je obróbce wideo. W trakcie obróbki można zaprogramować na twarzy niektóre ruchy mimiczne, co umożliwia obejście systemów autentykacji.

Firma iProov zaobserwowała w II półroczu 2023 roku wzrost liczby ataków związanych z zamianą twarzy o 704$ wobec I półrocza. W analogicznym okresie ataki na sieci mobilne wzrosły o 255%, a stosowanie emulatorów o 355%.

Zamiany twarzy i emulatory najbardziej popularne

To sprawia, iż zamiana twarzy i emulatory to w tej chwili zdecydowanie preferowane narzędzia wykorzystywane przez przestępców chcących dokonać oszustwa dotyczącego tożsamości. Narzędzia takie jak DeepFaceLive, Swapface, Deepswap i Swapstream.ai stały się bowiem łatwo dostępne.

Fakt, iż większość tych narzędzi oferuje użytkownikom bezpłatny poziom eksperymentowania, sprawia, iż atakującym jeszcze łatwiej jest je wykorzystać bez wydawania pieniędzy. A firma iProov zidentyfikowała już łącznie ponad 110 narzędzi umożliwiających zamianę twarzy.

Amerykańska firma konsultingowa Gartner twierdzi, iż do 2026 r. wykorzystywanie deepfakes do ataków na dane biometryczne twarzy spowoduje, iż 30% firm nie będzie już uważać biometrii za metodę niezawodnego uwierzytelnienia.

Wiele instytucji jest przekonanych, iż potrafi wykryć deepfake. Tak sądziło np. w 2022 roku 57% instytucji ankietowanych przez iProov. Po przeprowadzeniu eksperymentu okazało się, iż w rzeczywistości tylko 24% podmiotów poradziło sobie z wykryciem zjawiska deepfake.

Czytaj też: Technologia McAfee rozpozna deepfake w dźwięku

Czytaj też: Deepfake w spotach wyborczych. Google zaostrza regulamin

Źródło zdjęcia: Kyle Glenn/Unsplash