Automatyzacja procesów redakcyjnych miała być remedium na przeciążenie informacyjne, a tymczasem staje się kolejnym źródłem niepewności. Gdy algorytmy potrafią tworzyć całe artykuły, a jednocześnie generować masową dezinformację, rodzi się pytanie: czy media nadążają za technologią, która zmienia samą istotę ich misji?

Rosnąca liczba europejskich redakcji włącza sztuczną inteligencję do codziennej pracy, widząc w niej zarówno szansę, jak i zagrożenie. najważniejszy wydaje się model hybrydowy – połączenie ludzkiego nadzoru z automatyzacją – który, jak wskazują obserwatorzy rynku, może być najskuteczniejszą odpowiedzią na zalew fałszywych treści. Pozwala on wykorzystać moc obliczeniową do szybkiej weryfikacji danych, zachowując jednocześnie element krytycznej oceny, której algorytmy wciąż nie opanowały.

Problem polega na tym, iż wdrożenie takiego podejścia jest trudniejsze, niż zakładają jego entuzjaści. Automatyzacja rutynowych zadań ujawniła bowiem, jak skomplikowane wyzwania stawia przed mediami błyskawiczny postęp technologiczny. AI nie tylko zwiększa efektywność pracy, ale także wprowadza nowe ryzyka – od manipulacji algorytmami po podważanie autentyczności informacji. Czy zatem hybrydowy model to trwałe rozwiązanie, czy raczej próba opóźnienia nieuchronnego kryzysu zaufania?

Czynnik ludzki – fundament czy ograniczenie?

Badania jednoznacznie pokazują, iż ludzka obecność w procesie twórczym pozostaje kluczowa. Dotyczy to nie tylko samego pisania, ale także opracowywania narzędzi weryfikacyjnych, bez których walka z dezinformacją byłaby skazana na porażkę. Jednak w wielu redakcjach brakuje kompetencji technologicznych, co stawia pod znakiem zapytania zdolność tych mediów do skutecznej adaptacji.

Profesjonaliści branży medialnej coraz częściej apelują o szeroko zakrojone szkolenia z zakresu AI, podkreślając, iż bez tych umiejętności dziennikarze stają się zakładnikami technologii, którą powinni kontrolować. Czy można mówić o niezależnym dziennikarstwie, jeżeli redakcja nie rozumie mechanizmów działania narzędzi, na których opiera swoją pracę?

Pętla sprzężenia zwrotnego – jak zatrzymać spiralę fałszu?

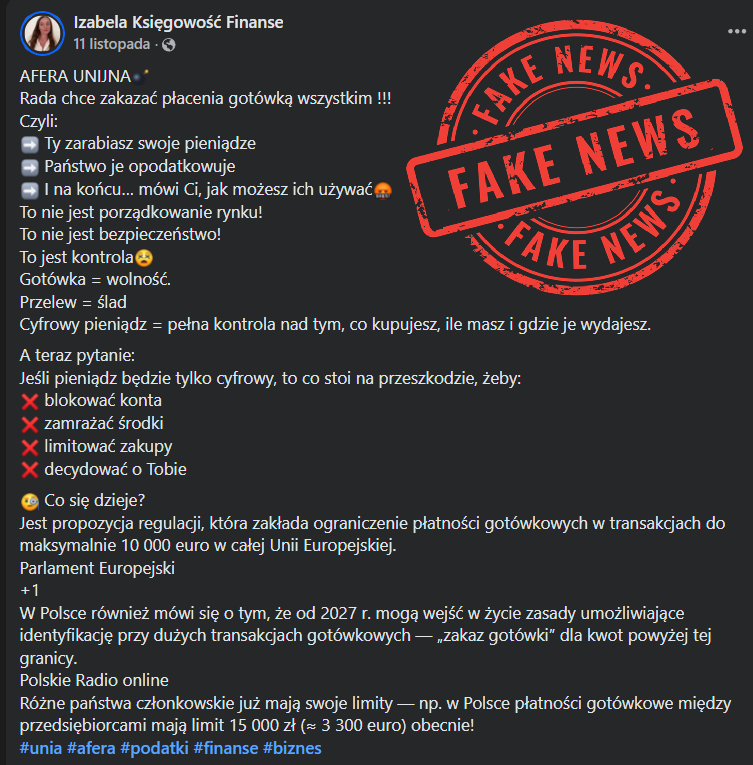

Problem dezinformacji nie kończy się na podaży fałszywych treści – równie istotny jest popyt. Susan D’Agostino, analizując zjawisko w „The Bulletin”, wskazuje na „pętlę sprzężenia zwrotnego dezinformacji”, w której algorytmy wzmacniają te treści, które generują największe zaangażowanie – niezależnie od ich prawdziwości.

Marshall Van Alstyne zwraca uwagę, iż bez uderzenia w obie strony – ograniczenia podaży i zmiany struktur napędzających konsumpcję – problem będzie się tylko pogłębiał. Proponowane rozwiązanie obejmuje jednoczesne blokowanie produkcji fałszywych informacji generowanych przez AI oraz transformację psychologiczną, technologiczną i kulturową środowiska, w którym się one rozprzestrzeniają. Czy to realne? A jeżeli nie, jak długo społeczeństwa będą w stanie odróżniać prawdę od cyfrowego mirażu?

Stronniczość algorytmów – problem techniczny czy systemowy?

Kwestia uprzedzeń wbudowanych w algorytmy jest jednym z najpoważniejszych wyzwań stojących przed nowoczesnym dziennikarstwem. Ramaa Sharma w swojej analizie podkreśla, iż skuteczna walka z tym zjawiskiem wymaga interdyscyplinarnych zespołów, zróżnicowanych zbiorów danych i wprowadzania standardów etycznych już na etapie projektowania narzędzi.

Do kluczowych działań zalicza się monitorowanie metadanych, stosowanie narzędzi wykrywających uprzedzenia, promowanie przejrzystości i współpracy międzyredakcyjnej. Jednak choćby najbardziej zaawansowane techniki nie zagwarantują sukcesu, jeżeli branża nie odpowie na pytanie: jaki jest koszt zaniechania? Czy media są gotowe przyznać, iż tolerowanie uprzedzeń technologicznych może oznaczać rezygnację z własnej wiarygodności?

Odpowiedź branży – chatboty jako nowa linia obrony

Niektóre redakcje podjęły próbę wypracowania rozwiązań niezależnych od globalnych platform. Rowan Philip opisuje eksperymenty wiodących organizacji z wewnętrznymi chatbotami opartymi na AI, które odpowiadają na pytania odbiorców wyłącznie na podstawie zweryfikowanych archiwów.

Takie podejście pozwala uniknąć ryzyka oparcia się na niepewnych źródłach sieciowych, gdzie popularne narzędzia, jak ChatGPT, korzystają z niezweryfikowanych danych. Co więcej, umożliwia to odbudowę zaufania poprzez transparentność i kontrolę nad procesem informacyjnym. Jednak czy lokalne rozwiązania obronią się w starciu z globalnym ekosystemem, w którym dominują algorytmy nastawione na zysk, a nie na prawdę?

Czy demokracja przetrwa erę automatycznego dziennikarstwa?

AI jest już integralną częścią europejskich redakcji, a jej wpływ na sposób tworzenia i odbioru wiadomości będzie tylko rósł. Problem w tym, iż wraz z korzyściami rośnie również ryzyko – od wzmocnienia dezinformacji po utratę wiarygodności mediów. Brak działań może doprowadzić do sytuacji, w której opinia publiczna przestanie wierzyć w jakiekolwiek informacje, co podważy fundamenty demokratycznego dyskursu.

Dlatego coraz częściej pojawiają się głosy, iż nie wystarczy samo techniczne dostosowanie – potrzebne są skoordynowane działania prawne, etyczne i kulturowe. Europejskie redakcje, wspierane przez decydentów, powinny wprowadzać zasady przejrzystości, uczciwości i niezależnego nadzoru nad narzędziami AI. Bez tego dziennikarstwo może stać się kolejną ofiarą technologii, która miała je uratować.

![#CyberMagazyn: DSA wprowadza cenzurę w krajach UE [OPINIA]](https://cdn.defence24.pl/2025/12/12/1200xpx/fg4gN7HPvHlS1j1zq5Ljo1S7yg0lQStq7h2f90eB.l35l.jpg)