„Dziecinna prowokacja” – tak Wołodymyr Zełenski nazwał w mediach społecznościowych spreparowane nagranie z 16 marca 2022 roku, w którym Rosjanie posłużyli się jego wizerunkiem, aby wezwać ukraińskich żołnierzy do złożenia broni. Kolejnego dnia w sieci zaczęło krążyć wideo z Władimirem Putinem informującym o zakończeniu wojny z Ukrainą. Materiały gwałtownie rozeszły się po Twitterze, Facebooku, YouTubie, Telegramie i w rosyjskim serwisie społecznościowym VKontakte. Prezydent Ukrainy jeszcze tego samego dnia odniósł się do sprawy i na Instagramie zdementował te informacje, na skutek czego portale zaczęły usuwać kopie fałszywych nagrań.

Aktualności „Pisma”

Raz w miesiącu poinformujemy Cię o najważniejszych materiałach z numeru, nowych podcastach.

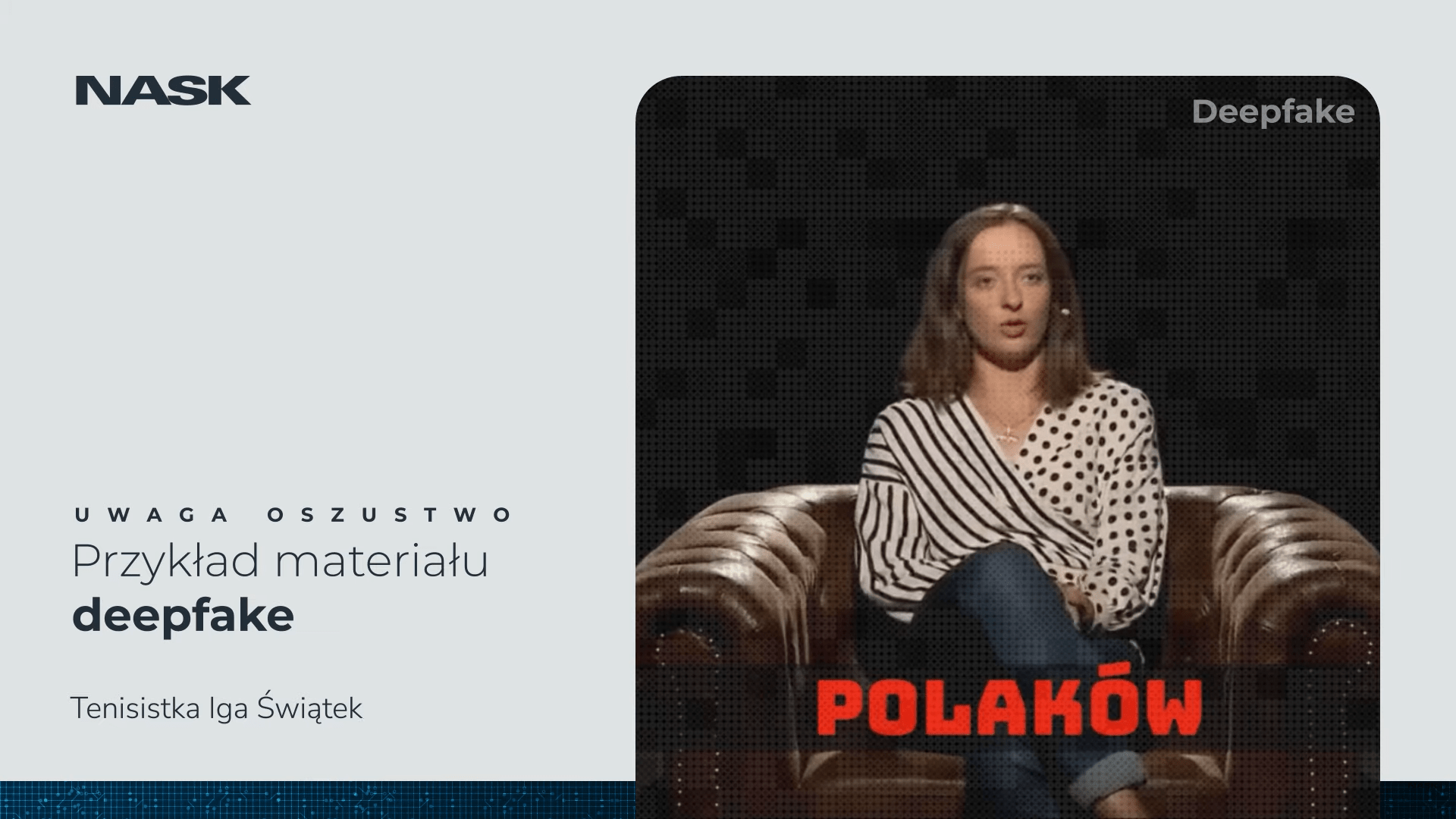

Zanim jednak oba filmiki ujrzały światło dzienne, ukraińskie Centrum Strategicznych Komunikacji i Bezpieczeństwa Informacyjnego sygnalizowało, iż Rosjanie mogą upublicznić tego typu fałszywkę. Kiepska jakość pierwszego nagrania (zaburzone proporcje głowy względem ciała, nienaturalny głos), przecieki na temat rosyjskich planów posłużenia się wizerunkiem Zełenskiego oraz popularność medialna prezydenta Ukrainy umożliwiły szybkie zdementowaniedeepfake’a.

„Ten [deepfake] z prezydentem Zełenskim rzeczywiście był niedoskonały, nie do końca wiemy, kto za nim stoi. jeżeli Rosjanie chcieliby wypuścić wysokiej jakoścideepfake, to pewnie byliby to w stanie zrobić” – komentowała dla CyberDefence24 Monika Borycka, założycielka firmy TrendRadar zajmującej się między innymi konsultacjami z zakresu technologii i nowych mediów. Stąd też owa „dziecinna prowokacja” – jak określił całe zamieszanie Zełenski – wydaje się zasadnym komentarzem. Gdyby jednak materiał został przygotowany lepiej i gdyby faktycznie zaskoczył ukraińskich żołnierzy oraz samego prezydenta Ukrainy, sfabrykowane wideo mogłoby zaważyć na losach wojny rosyjsko-ukraińskiej, przyczyniając się do kapitulacji strony ukraińskiej. Pytanie o to, czym zatem jest technologia, która może wpłynąć na przyszłość całych państw, wydaje się szczególnie istotne.

Deepfake– początki

Sam termindeepfakejest stosunkowy młody. Pochodzi od zestawieniadeep learning(„głębokie uczenie”, stanowiące podkategorię uczenia maszynowego sztucznej inteligencji) orazfake(„fałsz”). Na salony trafił za sprawą anonimowego użytkownika o nicku Deepfakes, który w 2017 roku opublikował na forum Reddit filmy porno z wizerunkami między innymi aktorek Gal Gadot czy Maisie Williams.

Na wyjściudeepfake’owegomateriału otrzymujemy fotos, nagranie audio lub wideo z obrazem kogoś, kto nie uczestniczył w tym procesie jako model, aktor bądź narrator. Intencja jego powstania może być różna – punktem wspólnymdeepfake’ówjest to, iż odbiorczyni lub odbiorcy trudno gołym okiem dostrzec fałszywkę.

Punktem wspólnymdeepfake’ówjest to, iż odbiorczyni lub odbiorcy trudno gołym okiem dostrzec fałszywkę.

Na wejściu potrzebnych jest kilka materiałów: tradycyjnie wykonane nagranie bądź zdjęcie, które ma zostać zmodyfikowane, a także materiały audio-wideo i fotografie (im liczniejsze, tym lepiej) z wizerunkiem osoby, która ma zostać poddana manipulacji – oraz odpowiedni program, komputerowy kod, który „domyśli się”, jak dana osoba mogłaby wyglądać w zaplanowanej sytuacji, i stworzy finalny obraz.

Kod ten bazuje na generatywnych sieciach przeciwstawnych (GAN, ang.generative adversarial networks), które składają się z generatora i dyskryminatora, czyli dwóch współpracujących ze sobą sieci neuronowych (systemów do przetwarzania informacji wzorowanych w pewnym stopniu na budowie systemu nerwowego). W trakcie pracy generator układa zestaw rzeczywistych i fikcyjnych (spreparowanych przez siebie) materiałów. W kolejnym kroku dyskryminator klasyfikuje je jako prawdziwe albo fałszywe. Im więcej danych zostanie dostarczonych, tym większa precyzja dyskryminatora w określaniu tego, co jest, a co nie jest rzeczywiste. A im większa precyzja, tym dokładniejsze obrazy są wytwarzane przez generator.

Autorem tej technologii jest (obecnie związany zawodowo z Google’em, wcześniej z Apple’em) amerykański informatyk Ian Goodfellow, który opracował ją z zespołem w 2014 roku. W kolejnych latach technologia była doskonalona przez innych badaczy (wytwarzane początkowo obrazy miały niską rozdzielczość i nie były specjalnie różnorodne).

Jedną z pierwszych metod tworzeniadeepfake’ówbyłconditional adversarial autoencoder(CAAE), warunkowy autoenkoder przeciwstawny, wykorzystywany do postarzania twarzy. Dzięki niemu można wytworzyć obraz adekwatny do wskazanego parametru wieku. Co ciekawe, na potrzeby modyfikacji naszej fizjonomii mechanizmowi CAAE nie potrzeba wielu zdjęć. Użytkowniczki i użytkownicy Facebooka mogą kojarzyć go z popularnej swego czasu aplikacji udostępnionej na platformie. Takich technik, podobnie jakface swapping(podmiany twarzy), na potrzeby wytwarzaniadeepfake’ówjest wiele.

W Polsce badania na ten temat prowadzą pracownicy Wydziału Elektroniki Wojskowej Akademii Technicznej w Warszawie, profesor Zbigniew Piotrowski oraz porucznik Tomasz Walczyna. W pracyQuick Overview of Face Swap Deep Fakes(Szybki przegląddeepfake’ów typu face swap) naukowcy wymieniają i porównują ze sobą opisane wyżej GAN, autoenkodery (AEs, ang.autoencoders) i modele dyfuzyjne (ang.diffusion models), czyli bardziej zaawansowane modele manipulacji obrazami i dźwiękami, aby przyjrzeć się szczegółom wytwarzaniadeepfake’ów– i podjąć refleksję nad kierunkiem, w jakim mogą się dalej rozwijać. Bo to, iż technologie dotyczące zamiany twarzy i nowe możliwości, które się w związku z tym wyłaniają, będą mieć coraz większe znaczenie w kontekście pomysłów na wykorzystywaniedeepfake’óww rozlicznych dziedzinach ludzkiego życia, nie ulega wątpliwości.

AI a rozgrywki polityczne

Naturalnym obiektem tej wyrafinowanej manipulacji są politycy najwyższych szczebli, choć do tej pory technologia ta nie zaważyła (jeszcze) na przebiegu konfliktu zbrojnego. Dziesięć miesięcy po opublikowaniudeepfake’ówz Wołodymyrem Zełenskim i Władimirem Putinem w roli głównej w stolicy Francji odbyły się protesty przeciw podniesieniu wieku emerytalnego z sześćdziesięciu dwóch do sześćdziesięciu czterech lat, forsowanemu przez Emmanuela Macrona. Internet obiegły liczne fotografie, na których prezydent uczestniczy w wydarzeniach: manifestuje na tle barykad z opon, ma na sobie żółtą kamizelkę ochronną (mającą symbolizować solidarność z ruchem społecznym „żółtych kamizelek”, którego przedstawiciele protestują przeciwko wyższym kosztom życia), ucieka przed policją bądź na tle ognia, zmęczony, czeka na rozwój wydarzeń. Materiały, które krążyły w sieci – nieco odrealnione, w baśniowej estetyce – od początku były oznaczone jako wytwór sztucznej inteligencji (hasztag#midjourney). Intencją pomysłodawców było jednak raczej ironiczne odwrócenie sytuacji niż przekonanie społeczeństwa, iż prezydent Macron protestuje przeciwko samemu sobie.

W tym kontekście nie sposób pominąć Stanów Zjednoczonych i centralnej postaci tej opowieści, byłego prezydenta Donalda Trumpa. Już w 2018 roku w sieci można było obejrzeć spreparowane wideo, na którym przywódca USA wzywa Belgię do wycofania się z paryskiego porozumienia klimatycznego. Wśród użytkowników sieci nagranie wywołało oburzenie, iż amerykański prezydent ingeruje w politykę wewnętrzną Belgii.

Wybór zagraniczny

Co w prasie zagranicznej zainspirowało Marcina Czajkowskiego, redaktora i fact-checkera w „Piśmie”?

O ile fałszywe fotografie z aresztowania przez policję, które obiegły sieć w marcu 2023 roku, nie były zbyt przekonujące, zwłaszcza iż podczas rzekomego zatrzymania Trump był inaczej ubrany na różnych obrazach – o tyle wygenerowane przez jego zwolenników, zmanipulowane ilustracje rzekomych czarnoskórych wyborców nie są już tak jednoznaczne w odbiorze. Niezależnie od prób rozbrojenia tego tematu przez media (przede wszystkim przez BBC News, gdzie Marianna Spring, dziennikarka specjalizująca się w tematyce dezinformacji, wnikliwie analizowała wybrane fotografie) działania te mogą mieć wpływ na tegoroczną kampanię prezydencką w USA poprzez zdobycie dzięki manipulacji dodatkowych głosów Afroamerykanów. A inne tego typudeepfaki, które jeszcze nie powstały – na przyszłe kampanie wyborcze, także w innych miejscach świata.

W tym kontekście warto przywołać też sytuację z początku 2024 roku. W amerykańskim stanie New Hampshire od 5 do 25 tysięcy wyborców otrzymało telefon ze zmodyfikowanym (jak się później okazało) głosem Joego Bidena, zniechęcającym ich do udziału w prawyborach. Do oszustwa przyznał się konsultant sztabu Deana Phillipsa, kontrkandydata Bidena, zapewniając, iż był to jego pomysł.

Nie dziwi więc, iż sztuczna inteligencja budzi niepokój. Nie pomaga wielokrotne spotykanie się z nią w kontekście dynamicznych zmian na rynku pracy, najczęściej na poziomie średnio wyrafinowanego hasła „niedługo z powodu AI zostaniesz bez zatrudnienia” (choć w przypadku przeważającej części zawodów trudno sobie wyobrazić, jak to odbieranie pracy miałoby wyglądać). Gdzieś w tle pulsuje także budzący obawę już od lat 20. XX wieku wizerunek myślącego androida, który w filmachscience fictionskutecznie dorównuje inteligencją człowiekowi, a czasem wręcz go przewyższa. Fakt, iż niełatwo wyjaśnić zasady działania AI prostym językiem (a do pewnego stopnia jest to niemożliwe – jako ludzie, z naszym aparatem poznawczym, nie jesteśmy w stanie dogonić tej mnogości procesów, które zachodzą w odosobnieniu algorytmów), także nie działa korzystnie PR-owo.

W tym kontekście technologiadeepfake, która sprawia, iż w sposób prawie magiczny można podmieniać twarze, ruchy i głosy, musi wzbudzać niepewność i lęk. Nagle okazało się, iż obca osoba spotkana w internecie – mimo miłej aparycji i składnego wysławiania się – niekoniecznie jest żywym człowiekiem, a widziane nagranie lub zdjęcie – prawdą.

Nagle okazało się, iż obca osoba spotkana w internecie – mimo miłej aparycji i składnego wysławiania się – niekoniecznie jest żywym człowiekiem, a widziane nagranie lub zdjęcie – prawdą.

Szczególnie istotnym problemem sądeepfakina żywo – cyfrowe nakładanie cudzej twarzy na „aktora” w czasie rzeczywistym: podczas egzaminów online czy rozmów kwalifikacyjnych (podszywanie się lepiej przygotowanej osoby pod kandydata), kontaktów służbowych czy prywatnych czatów. Przy braku czujności skutki mogą być dotkliwe i dla zawodowej reputacji, i dla portfela. Na początku tego roku sieć obiegła informacja, iż pracownik oddziału pewnej firmy w Hongkongu (dane firmy zostały utajnione) po spotkaniu online z rzekomym dyrektorem generalnym i grupą kolegów przelał na konto oszustów około 26 milionów dolarów. Niestety, ani dyrektor, ani koledzy nie byli tym, kim mieli być. Mężczyzna otrzymał mailowo polecenie przelewu, a zaraz później link do spotkania online.

Udział w wideokonferencji uspokoił pracownika – w jej trakcie zobaczył ludzi, których znał. Nie zdawał sobie jednak sprawy, iż ma do czynienia z przestępcami, którzy dzięki specjalnego systemu cyfrowo nałożyli na siebie w czasie rzeczywistym twarze przedstawicieli firmy. Narzędzia do takich czynności w tej chwili są już powszechne, a taką podmianę (abstrahując od celów) można wykonać samodzielnie na własnym komputerze. W sieci znajdziemy sporo tutoriali, w tym także polskojęzycznych.

Deepfakiodbijają się czkawką także dostawcom systemów zabezpieczających bazujących na rozwiązaniach biometrycznych i wymagają od nich zapewniania klientom większego bezpieczeństwa. Działania te przyjmują również formę projektów współfinansowanych z funduszy unijnych, jak uruchomiony w styczniu 2024 roku projekt „Vesper – bezpieczna platforma komunikacji głosowej z integracją usług biometrycznych”. Mają dzięki niemu powstać „technologie mają[ce] (…) zabezpieczyć użytkownika przed atakami prezentacji oraz uniemożliwić wykorzystanie głosu rozmówcy do skutecznej realizacjideepfakeprzy użyciu technik syntezy głosu”.

Przeczytaj też:Dezinformacja w sieci jak wirus

W Europie przetwarzanie danych wrażliwych, do których zaliczają się dane biometryczne, jest poddane szczególnej ochronie na mocy rozporządzenia o ochronie danych osobowych (RODO). Zgodnie z nim dane biometryczne to dane, które „wynikają ze specjalnego przetwarzania technicznego, dotyczą cech fizycznych, fizjologicznych lub behawioralnych osoby fizycznej, umożliwiają lub potwierdzają jednoznaczną identyfikację …