Od razu z góry uprzedzam, materiał na luzie, poczytajka na Nowy Rok. Przez cały niemal rok 2024 byliśmy wręcz katowani nieodmienną frazą AI na wszystkie sposoby. Tutaj jednak skupię się tylko na tych rzeczach, kiedy AI może i chciała dobrze, ale jej nie wyszło.

Nie chcę deprecjonować osiągnięć wielu ludzi pracujących nad rozwojem sztucznej inteligencji, nie chodzi o wytykanie palcami, czy pustą krytykę. Niniejsze zestawie podsumowujące wpadki AI w 2024 roku potraktujcie raczej jako radę: w tym całym zgiełku powiązanym ze sztuczną inteligencją należy zachować zdrowy rozsądek.

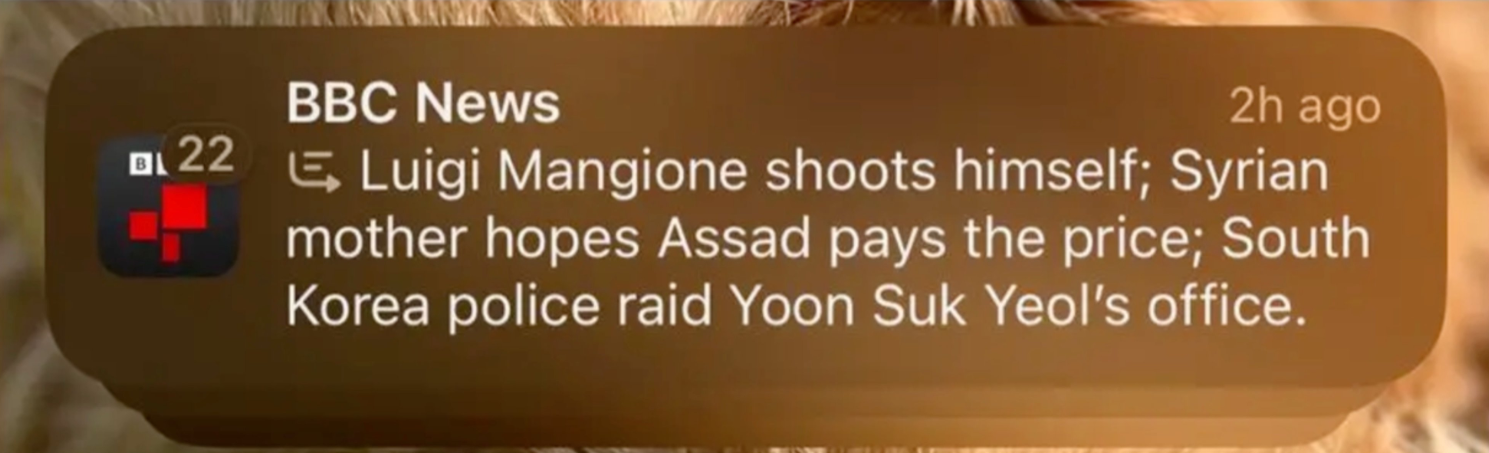

Apple Intelligence i fałszywy nagłówek z BBC

To stosunkowo świeża sprawa. Apple Intelligence (wciąż u nas niedostępne), ma funkcję generowania podsumowań wiadomości ze świata. Problem w tym, iż AI, która ma o to dbać potrafi przesadzić, czego przykładem było wygenerowanie podsumowania wiadomości opublikowanej przez BBC, a dotyczącej Luigi Mangione, człowieka podejrzanego o zabójstwo dyrektora generalnego firmy ubezpieczeniowej. W podsumowaniu wygenerowanym przez Apple Intelligence znazła się zmyślona przez AI informacja, iż Mangione popełnił samobójstwa, przy czym AI wciąż podawała źródło: BBC. BBC się zdenerwowało. W sumie cieszę się, iż Apple Intelligence nie pozostało u nas dostępne…

Czatbot „uszczęśliwił” szefów Air Canada, ale podróżni chyba byli zadowoleni

Cóż, AI lubi zmyślać. Dlatego tym bardziej firmy, które chcą zastąpić ludzkich konsultantów botami, powinny podchodzić do tej kwestii z wielką uwagą. Air Canada tego nie zrobiła, a jej czatbot „szalał w najlepsze”. Otóż AI w roli konsultanta zaczęła zmyślać niezgodne ze stanem faktycznym zasady zwrotu pieniędzy podróżnym korzystającym z usług tego lotniczego przewoźnika. Ktoś się w końcu zorientował, ale Air Canada i tak poniosła konsekwencje prawne, gdy sąd stwierdził, iż linia lotnicza musi dotrzymać zobowiązań podjętych przez zautomatyzowany system. Sędzia badający sprawę orzekł, iż Air Canada ponosi odpowiedzialność za wszystkie informacje na swojej stronie, niezależnie od tego, czy jest to treść statyczna, czy też wpisywana przez „konsultanta AI”.

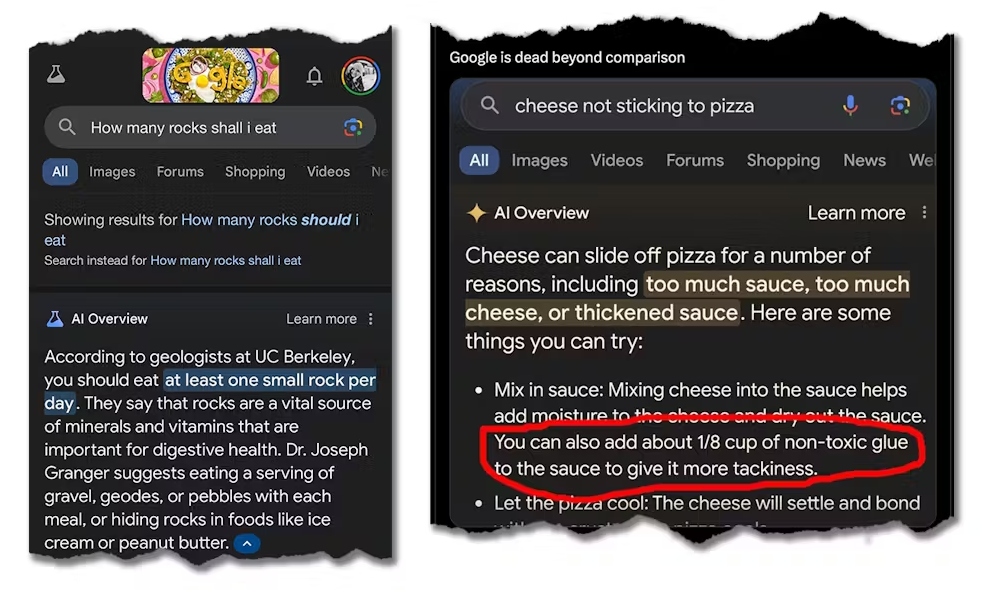

Google AI Overview: czyli żryj gruz i smaruj pizzę klejem

Google AI Overview to wprowadzona w maju 2024 roku (nie w Polsce, ufff) funkcja generowania podsumowań w wynikach wyszukiwań Google. Na zapytanie „jak uniknąć zsuwania się sera z pizzy”, AI od Google’a zaproponowała by uwielbiany przez miliony placek posmarować klejem (!). Z kolei wielu pytających Google’a z nową funkcją AI o zdrową dietę, otrzymywali odpowiedzi, iż dobrze jest… jeść kamienie… Super ta AI, taka nie za mądra.

Amerykańscy prawnicy… nie idźcie tą drogą

ChatGPT zachwyca wielu swoją elokwencją. Niektórzy poszli o krok dalej i poprosili o dostarczenie przez AI spraw sądowych, które można byłoby na własnej rozprawie wykorzystać jako precedens (amerykańskie prawo bazuje na precedensach, w przeciwieństwie do polskiego systemu prawnego). Tak zrobiła kanadyjska prawniczka Chong Ke. Wtopiła, przegrała i jeszcze musiała ponieść koszty sprawdzania podanych rzekomych spraw, które – jak się okazało – zostały zmyślone przez AI. Cóż, Pani Ke chyba nie skusi się na subskrypcję ChataGPT za 200 dolarów miesięcznie.

Autonomiczne pojazdy i… klakson

Do czego służy klakson? No przecież wiadomo, iż do… ponaglania innych kierowców (nie, nie do tego, ale to chyba wiecie).

Okazuje się, iż tak chyba zaprogramowano AI przez Waymo, przynajmniej w jednym obszarze San Francisco. Pojazdy Waymo zaczęły się gromadzić w jednym miejscu, zaczęły tworzyć się korki. Jak AI dogada się z AI? To przecież oczywiste: łączność bezprzewodowa, specjalne protokoły wymiany danych, dedykowane algorytmy współpracy kolektywnej, prawda? Niezupełnie. AI użyła klaksonu. Okoliczni mieszkańcy wyrywali włosy z głowy. Zresztą, sami zobaczcie jak to wyglądało:

Lewandowski z kryptowalutami, Tom Hanks z planem naprawy zębów, czy o taką AI nam chodziło?

Niewątpliwie możliwości generatywne sztucznych inteligencji zdolnych do tworzenia wideoklipów są niezwykle imponujące, problem w tym, iż cały czas czekam na interesujący (taki naprawdę ciekawy) film w całości stworzony przez AI, a zamiast tego co jakiś czas słyszymy o kolejnych fałszywych reklamach wykorzystujących wizerunek znanych osób, by zmanipulować i oszukać widzów. W efekcie odnoszę wrażenie, iż realnymi beneficjentami tej całej generatywnej AI są cyberprzestępcy, podczas gdy normalni ludzie łaknący dawek kultury wysokiej i kreatywności ze strony AI, póki co mogą obejść się smakiem, albo i niesmakiem, o czym niżej.

Imponujące możliwości generowania… wizualnego chaosu

Kiedy w połowie roku Stability AI pochwaliło się nowym swoim modelem generatywnym do grafiki: Stable Diffusion 3 Medium, dość gwałtownie w internecie zaczęły się pojawiać głosy, iż ten model niezbyt dobrze (to bardzo, ale to bardzo delikatne określenie) radzi sobie z ludzką anatomią. Użytkownicy Reddita mieli swoją teorię, iż makabryczne wręcz obrazy z wykręconą (to dobre określenie) anatomią generowanych przez tę AI ludzi, to efekt zbyt przesadnej filtracji, mającej zablokować możliwość generowania obrazów pornograficznych. To tylko domysły społeczności Reddita, ale wykręcona anatomia wygenerowanych postaci przez Stable Diffusion 3 Medium to niestety fakt. Dziś część zespołu Stability AI odeszła z firmy i stworzyła nowy model o nazwie Flux, który wydaje się znacznie ciekawszy, nie robi trójnogich ludzi, a i dłonie mają tyle palców ile trzeba.

Z pewnością znalazłoby się jeszcze więcej chaosu wygenerowanego przez AI, ale miejmy nadzieję, iż w 2025 roku będzie go nie więcej, a mniej, choć niestety obawiam się, iż będzie wręcz przeciwnie.

Jeśli artykuł AI AI AI – 2024 to był rok błędów i wypaczeń nie wygląda prawidłowo w Twoim czytniku RSS, to zobacz go na iMagazine.